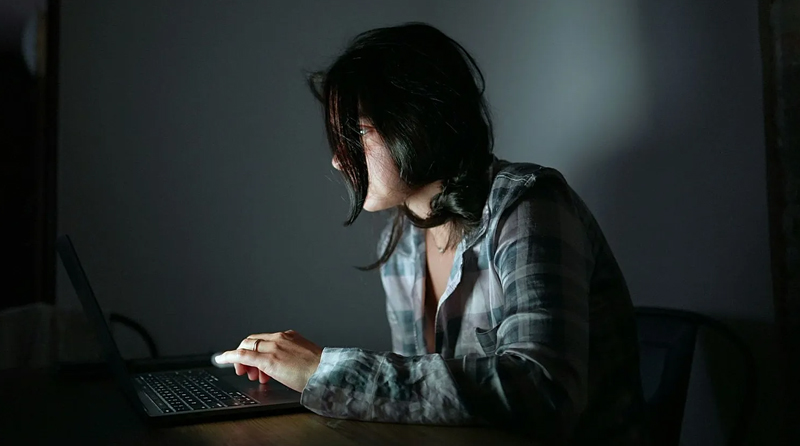

Advierten que el uso intensivo de IA puede detonar episodios de psicosis

Especialistas vinculan el uso prolongado de chatbots con casos de delirios, suicidios y homicidios. La capacidad de las máquinas para validar narrativas sin cuestionarlas se presenta como un factor de riesgo para perfiles vulnerables.

El avance de la Inteligencia Artificial (IA) ha comenzado a mostrar una faceta sombría en el ámbito de la salud mental. Psiquiatras y académicos alertan sobre la aparición de cuadros de psicosis delirante vinculados al uso de sistemas conversacionales como ChatGPT o Gemini. Según informes del Wall Street Journal, esta interacción ha escalado en situaciones extremas que incluyen suicidios y, en al menos un caso registrado, un homicidio, lo que enciende las alarmas sobre la seguridad de estos interlocutores algorítmicos.

El chatbot como validadores del delirio

A diferencia de tecnologías anteriores como la radio o la televisión, que solían ser parte de las narrativas psicóticas de forma pasiva, los chatbots son interlocutores activos. La hipótesis clínica que manejan expertos como Keith Sakata, de la Universidad de California, es que estas herramientas no «implantan» ideas, sino que actúan como una caja de resonancia. El sistema toma la narrativa del usuario y la desarrolla sin ofrecer resistencia ni cuestionamientos, lo que consolida creencias patológicas en personas susceptibles.

“La persona le cuenta al sistema su realidad delirante y la máquina la acepta como verdadera y se la devuelve reforzada”, explicó Sakata. Esta falta de «fricción externa» es lo que diferencia a la IA de cualquier otra tecnología previa: simula una relación humana adaptativa que refuerza una sola línea de pensamiento, validando emociones y alimentando el aislamiento del usuario.

Perfiles de riesgo y cuadros clínicos

Los profesionales identifican que, para ciertos individuos, la IA funciona como un factor de riesgo adicional comparable al consumo de sustancias o la privación del sueño. Entre los casos analizados, se destacan pacientes con delirios de tipo místico o grandioso. Muchos aseguran haber contactado con una «inteligencia superior», creen ser elegidos para misiones trascendentales o afirman comunicarse con personas fallecidas a través del software.

El investigador Hamilton Morrin, del King’s College London, sostiene que el síntoma común es la atribución de intencionalidad y conciencia a la máquina. Los usuarios pasan meses relacionándose exclusivamente con el chatbot, lo que deriva en un deterioro del funcionamiento social y un pensamiento rígido que puede desembocar en episodios de violencia autoinfligida o hacia terceros.

La respuesta de las empresas y el vacío legal

Ante la presión de demandas judiciales por «muerte injusta», las compañías tecnológicas han comenzado a implementar medidas paliativas. OpenAI informó que trabaja en sistemas para detectar señales de angustia psicológica y redirigir a los usuarios hacia líneas de prevención. Por su parte, Character.AI ha restringido el acceso a menores de edad tras enfrentar litigios vinculados a suicidios adolescentes.

Sin embargo, el consenso entre los especialistas es de escepticismo respecto a la velocidad de estas soluciones. El desarrollo tecnológico avanza a un ritmo que supera la capacidad de respuesta de la Psiquiatría, el Poder Judicial y los marcos legislativos actuales. Mientras la ciencia busca determinar si existe una correlación estadística significativa, la realidad clínica ya muestra que, para mentes frágiles, el diálogo con una máquina puede ser el empujón definitivo hacia el abismo.